Tout juste quarante ans après sa mort, il reste le plus grand physicien britannique de tous les temps avec Isaac Newton. L’un des pionniers de la physique quantique, annonciateur du positron, peu sociable mais véritable génie des mathématiques, aurait été atteint du syndrome d’Asperger, selon une récente biographie.

Imaginez que vous ayez 31 ans, que vous ayez soutenu votre thèse de doctorat sept ans plus tôt, publié déjà plus d’une dizaines d’articles majeurs dans des revues scientifiques d’importance internationale, et qu’on vous propose le Prix Nobel de Physique. À l’époque, on pouvait même l’avoir avant la soutenance. C’était en 1933, période particulièrement noire dans le contexte international, mais aussi période passionnante de la mise en forme de la physique quantique qui a occupé toute la première moitié du XXe siècle.

Paul Dirac a disparu il y a exactement quarante ans le 20 octobre 1984 à l’âge de 82 ans, à Tallahassee, en Floride. Ce grand physicien a fait partie des pères fondateurs de la physique quantique, aux côtés de Max Planck, Niels Bohr, Albert Einstein, Werner Heisenberg, Erwin Schrödinger, etc. Il fut l’un des trois plus grands physiciens du XXe siècle et cet anniversaire est l’occasion pour moi de le faire mieux connaître, car je trouve qu’il manque injustement de notoriété.

Un des plus grands génies de tous les temps

Prix Nobel en 1933, Paul Dirac fut un véritable génie, uniquement tourné vers ses recherches sur la théorie quantique. Toute sa vie n’a été qu’attention portée aux équations.

Selon l’épistémologue Norwood Russell Janson (1924-1967), ardent défenseur de l’interprétation de Copenhague, cité dans un article publié en 1980, la parution de la théorie relativiste des électrons de Paul Dirac en 1928 a été l’un des événements les plus marquants de l’histoire des sciences : « Theoretical physics has rarely witnessed such a powerful unification of concepts, data, theories and intuitions : Newton and Universal Gravitation ; Maxwell and Electrodynamics ; Einstein and Special Relativity ; Bohr and the hydrogen atom ; these are the high spots before Dirac. From a chaos of apparently unrelated facts and ideas, Newton in his way, and now Dirac in his, built a logically powerful and conceptuelly beautiful physical theory. » [La physique a rarement vu une unification aussi puissante de concepts, de données, de théories et d’intuitions : Newton et la Gravitation universelle ; Maxwell et l’Électrodynamique ; Einstein et la Relativité restreinte ; Bohr et l’atome d’hydrogène ; ce sont les grands éclairs avant Dirac. D’un chaos apparemment sans relation de faits et d’idées, Newton à sa manière, et maintenant Dirac à la sienne, ont construit une théorie physique logiquement solide et conceptuellement pleine de beauté] ("The Concept of the Positron", Cambridge, 1963 ; p. 146).

La beauté, c’est ce qui a obsédé Paul Dirac toute sa vie. Mais pas la beauté féminine : « This result is too beautiful to be false ; it is more important to have beauty in one’s equation than to have them fit experiment. » [Ce résultat est trop beau pour être faux ; il est plus important d’avoir la beauté dans les équations que de les voir confirmer par l’expérience] ("The evolution of the Physicist’s Picture of Nature", Scientific American, 208, 5, 1963).

La bosse des maths

Du côté de son père, qui enseignait le français, et comme son nom francophone l’indique, il était d’origine suisse (Valais) et française (Charente). Né le 8 août 1902 à Bristol, Paul Adrien Maurice Dirac était un fou de mathématiques dès son plus jeune âge. Il a suivi des études d’ingénieur en électricité à Bristol. À cause du climat économique très maussade, diplômé en 1921, il n’a pas trouvé de travail et finalement, a continué des études scientifiques à Cambridge parce qu’il était passionné par la théorie de la Relativité générale et qu’il avait réussi à obtenir une bourse.

En 1923, il travailla avec l’astrophysicien Ralph H. Fowler (1889-1944) sur la mécanique statistique des étoiles naines blanches. Six mois plus tard, il publia déjà ses deux premiers articles sur le sujet. En mai 1924, il publia son premier article sur la physique quantique. C’est en 1925 qu’il fit la rencontre essentielle de Niels Bohr (1885-1962) qui venait d’avoir le Prix Nobel en 1922, et de Werner Heisenberg (1901-1976), futur Prix Nobel en 1932. En novembre 1925, il avait publié quatre autres articles sur la théorie quantique. En tout, il a publié onze articles importants avant sa soutenance.

Paul Dirac a soutenu sa thèse en juin 1926 sur la physique quantique, en faisant, par une intuition géniale, une analogie entre la formulation matricielle que venait de proposait Werner Heisenberg pour décrire la physique quantique et les crochets de Poisson de la mécanique hamiltonienne, reformulation de la mécanique classique en 1833 par William Rowan Hamilton (1805-1865).

Un acteur majeur dans l’élaboration de la théorie quantique

Après son doctorat, il est parti rejoindre Niels Bohr à Copenhague puis en février 1927, Werner Heisenberg à Göttingen où il a travaillé avec Robert Oppenheimer (1904-1967), Max Born (1882-1970), Prix Nobel en 1954, James Franck (1882-1964), Prix Nobel en 1925, et Igor Tamm (1895-1971), Prix Nobel en 1958, puis il a collaboré quelques semaines avec Paul Ehrenfest (1880-1933) à Leyde (Pays-Bas) avant de revenir à Cambridge où il fut recruté comme Fellow du St John’s College. Invité au 5e congrès Solvay en septembre 1927, il fit la rencontre d’Albert Einstein (1879-1955).

Paul Dirac fit de nombreux voyages dans le monde, est allé pour la première fois en Union Soviétique en 1928, et aux États-Unis en 1929. Il s’amusait à profiter des colloques pour faire le tour du monde : après une visite aux États-Unis, il est allé directement au Japon et est rentré à Cambridge en prenant le Transsibérien.

À partir de ses premiers travaux où il "jouait" avec l’algèbre des opérateurs linéaires en introduisant la notation bra-ket (à partir du 29 avril 1939), il publia un recueil très pédagogique sur la nouvelle physique de l’atome (qui fait encore référence aujourd’hui) sous un titre assez banal : "Le Principe de la mécanique quantique" (éd. Oxford University Press) publié initialement le 29 mai 1930 (il n’avait alors que 27 ans !). L’ouvrage fut régulièrement réédité et complété, devenant l’un des manuels "classiques" pour la physique quantique (le dernier chapitre rédigé en 1947 dans la 3e édition présente l’électrodynamique quantique). On peut lire la quatrième édition révisée (publiée le 26 mai 1967) dans son intégralité ici.

Paul Dirac était avant tout un théoricien des mathématiques. Il se moquait des expériences sinon de la pensée (il préférait la beauté des équations, voir la citation ci-dessus), et a été celui qui a construit la plus solide architecture mathématique pour la physique quantique, reprenant les travaux d’Erwin Schrödinger et de Werner Heisenberg dont le formalisme mathématique manquait de cohérence et d’harmonie.

Cela lui valut le Prix Nobel de Physique en 1933 « pour la découverte de formes nouvelles et utiles de la théorie atomique », partagé avec Erwin Schrödinger (1887-1961), célèbre pour son équation d’onde et son expérience de la pensée résumée sous l’expression "le chat de Schrödinger" (en physique quantique, un chat pourrait être à la fois vivant et mort, d’où le paradoxe philosophique que posait cette théorie probabiliste). Un peu avant son Prix Nobel (il avait refusé d’inviter son père à la remise à Stockholm), Paul Dirac avait publié un article essentiel sur la mécanique quantique lagrangienne que développa plus tard Richard Feynman (1918-1988), Prix Nobel en 1965, qui fut beaucoup influencé par lui.

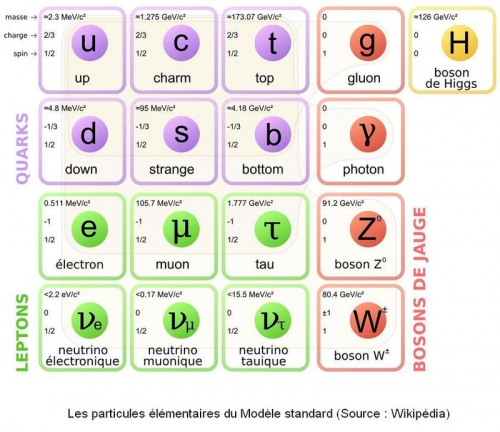

Le positron et l’antimatière, issus des équations de Dirac

Par ses avancées mathématiques, Paul Dirac a ainsi prédit en 1931 l’existence de l’antimatière, c’est-à-dire, des antiparticules, en particulier, du positron (aussi appelé positon pour les francophones), l’antiparticule associée à l’électron.

La raison, c’est que dans son équation qui décrit la mécanique quantique relativiste de l’électron (formulée en 1928), la description des particules se fait en fonction du carré de la charge électrique, laissant supposer que la charge d’une particule de même type (même masse et même spin) pourrait être positive ou négative. Jusqu’en 1932, cette idée était plutôt le point faible de sa théorie, car personne ne comprenait comment l’antimatière pouvait exister. Paul Dirac se moquait de l’imaginer, ses équations étaient trop belles pour être fausses !

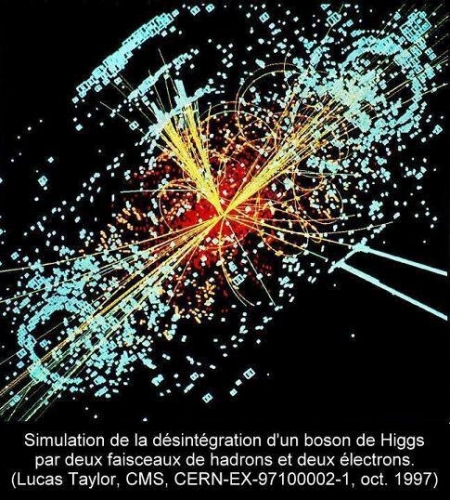

Par ailleurs, la collision d’une particule et de son antiparticule créerait une désintégration avec une forte dissipation d’énergie (émission de photon) qu’on peut retrouver dans la fameuse formule d’Einstein, E=mc2. C’est la base de toute la recherche sur les nouvelles particules élémentaires dans des accélérateurs à particules (fournir le plus d’énergie possible pour faire surgir de nouvelles particules).

Le positron fut découvert expérimentalement dès 1932 par Carl David Anderson (1905-1991) qui a vu la trace de « quelque chose de chargé positivement et de masse similaire à celle de l’électron » et cette découverte fut confirmée par Patrick Blackett (1897-1974) par l’observation de rayons cosmiques photographiés dans une chambre à brouillard qui est le premier détecteur de particules (certaines traces ne provenaient pas d’électrons mais d’électrons à charge positive).

Cette découverte valut Carl David Anderson le Prix Nobel en 1936 qui découvrit la même année le muon par le même type de détection. Quant à Patrick Blackett, il reçut le Prix Nobel en 1948 pour le développement de la chambre à brouillard conçue en 1911 par Charles T. R. Wilson (1869-1959) qui, lui aussi, avait obtenu le Prix Nobel en 1927. Sa chambre permettait de rendre visible, par condensation de la vapeur, la trajectoire des particules électriquement chargées.

Entre parenthèses, la découverte du positron est l’exemple même (il y en a plein d’autres) qui montre que la recherche scientifique n’a aucun sens réalisée de manière solitaire ou de manière nationaliste (et cela dans une période aux nationalismes exacerbés). Même si Paul Dirac travaillait plutôt seul (il détestait communiquer), il se nourrissait des travaux des autres, en particulier, pour son équation, des travaux d’Albert Einstein et de Wolfgang Pauli (1900-1958), Prix Nobel en 1945, pour donner les fondations théoriques des futures observations expérimentales. Et pour les expériences, il a fallu développer toute une instrumentation (Charles T. R. Wilson), puis utiliser l’appareil pour des applications données, être capable d’identifier une incompréhension de mesure par des théories récentes (Carl David Anderson) et de confirmer l’explication par des expériences focalisées sur cette découverte (Patrick Blackett). À noter également que d’autres physiciens reçurent le Prix Nobel pour le développement d’autres appareils de détection, comme Georges Charpak (1924-2010) qui fut récompensé en 1992 « pour son invention et le développement de détecteurs de particules, en particulier la chambre proportionnelle multifils ».

Lorsque Albert Einstein s’est retrouvé en 1933 parmi les membres de la direction de l’Institute for Advanced Study à Princeton, et qu’on lui a demandé qui il voulait recruter, le premier nom qu’il a proposé était Paul Dirac qui venait juste d’avoir le Prix Nobel. Paul Dirac passa donc une année académique (1934-1935) à Princeton où il sympathisa beaucoup avec son collègue Eugene Wigner (1902-1995), Prix Nobel en 1963. Venant de Budapest où elle habitait, la sœur de ce dernier est venue le visiter alors que Paul Dirac était présent à cette rencontre…

De Newton à Hawking

Entre 1932 et 1969, Paul Dirac fut titulaire de la prestigieuse chaire de mathématiques de l’Université de Cambridge. Parmi ses prédécesseurs l’illustre Isaac Newton (1643-1727) entre 1669 et 1702, et l’hydrodynamicien Georges Stokes (1819-1903), célèbre pour son équation de mécanique des fluides, de 1849 à 1903. Certains de successeurs sont également très connus : Stephen Hawking (72 ans) de 1979 à 2009 et, depuis le 1er novembre 2009, Michael Boris Green (68 ans), l’un des pionniers de la théorie des cordes en 1984.

Michael Boris Green fut d'ailleurs lauréat en 1989 du Prix et Médaille Paul Dirac, qui a récompensé entre autres en 1987 Stephen Hawking, en 1988 John Stewart Bell (1928-1990), auteur du fameux théorème de Bell, en 1989 Roger Penrose (83 ans) et en 1997, Peter W. Higgs (85 ans), Prix Nobel en 2013. Cette gratification est attribuée par l’Institute of Physics (l’équivalent britannique de la Société française de Physique).

Une autre récompense a été instituée en l’honneur de Paul Dirac, la Médaille Dirac créée par le Centre international de physique théorique (ICTP basé à Trieste) juste après la disparition de Paul Dirac, en 1985, pour honorer des chercheurs en physique théorique et en mathématiques qui n’ont pas été récompensés par le Prix Nobel ni la Médaille Field ni le Prix Wolf (très prestigieux aussi). Alan H. Guth (67 ans), l’inventeur de la théorie de l’inflation cosmique après le Big Bang, et Édouard Brézin (76 ans), ancien président du CNRS, en furent lauréats respectivement en 2002 et 2011.

Quelques intuitions très mathématiques

Très curieux et fin observateur, perspicace et rigoureux, Paul Dirac avait voulu comparer en 1937 deux rapports de grandeurs physiques. Le premier était la longueur de l’univers observable (rayon de Hubble) sur le rayon d’un électron. Le second l’intensité de la force gravitationnelle sur celle de la force électromagnétique appliquée entre deux électrons. Or, il avait remarqué que ces deux rapports étaient sensiblement équivalents, le premier de l’ordre de 2x1040 (nombre d’Eddington-Dirac) et le second de l’ordre de 3x1041.

C’était la première fois qu’un scientifique "mélangeait" l’infini grand et l’infiniment petit, et Paul Dirac considérait que l’équivalence n’était pas une coïncidence. En considérant que ces deux rapports restaient dans le même ordre de grandeur, et sachant que seule, la constante de Hubble variait avec le temps, Paul Dirac en avait conclu qu’une autre constante devait forcément varier en fonction du temps (si ces rapports restaient équivalents), et suggérait que cela devait être la constante de la gravitation qui serait inversement proportionnelle au temps, ce qui contredisait la théorie de la Relativité générale qui la prédisait constante (conservation de l’énergie), ou alors que la masse de l’univers serait proportionnelle au carré du temps. Ces deux hypothèses sont rejetées par les cosmologistes d’aujourd’hui.

Parmi les "objets" (de mathématiques ou de physique) attribués à Paul Dirac, on peut citer la constante de Dirac qui n’est que la constante de Planck réduite (h/2pi), la distribution de Dirac (aussi appelée fonction delta de Dirac) qui exprime une impulsion ponctuelle et qui permet de l’intégrer dans le calcul mathématique, le peigne de Dirac qui est un joli nom pour désigner une distribution de Dirac périodique, ces deux objets ont été repris et améliorés par le mathématicien français Laurent Schwartz (1915-2002), Médaille Field en 1950. Lui-même plutôt modeste, Paul Dirac a toute sa vie préféré parler de la "statistique de Fermi" pour évoquer la "statistique de Fermi-Dirac" qui décrit depuis 1926 les particules à spin demi-entier (fermions qui suivent le principe d’exclusion de Pauli), à opposer à la statistique de Bose-Einstein qui décrit les particules à spin entier (bosons pour lesquels le principe de Pauli ne s’applique pas). À cela, il faut aussi ajouter, dans ses contributions majeures, le positron prédit par Paul Dirac ainsi que les monopoles magnétiques.

Une tendance à tout théoriser

Dans une récente biographie, Graham Farmelo (61 ans), docteur en physique théorique des particules, évoque même le syndrome d’Asperger (une forme légère d’autisme) pour caractériser Paul Dirac, qui a détesté son père qui l’obligeait à lui parler uniquement en français (comme il n’en était pas capable, Paul Dirac gardait ainsi le silence) et il fut profondément troublé par le suicide de son frère Félix pendant la préparation de sa thèse (en mars 1925).

Il existe de nombreuses anecdotes qui racontent à quel point Paul Dirac pouvait déconcerter ses interlocuteurs au cours de sa vie professionnelle ou personnelle. Par exemple, le jour où il a rencontré pour la première fois le jeune Richard Feynman, il lui a dit : « I have an equation. Do you have one too ? » [J’ai une équation. En avez-vous une aussi ?]. Ou encore lors d’une conférence à Toronto, au moment des questions, quelqu’un dans la salle lui déclara : « Professor Dirac, I do not understand how you derived the formula on the left side of the blackboard. » [Professeur Dirac, je ne comprends pas comment vous dérivez la formule au côté gauche du tableau]. Ce à quoi Paul Dirac répondit : « This is not a question. It is a statement. Next question, please. » [Ce n’est pas une question. C’est un commentaire. Question suivante, s’il vous plaît]. Paul Dirac était connu pour dormir en écoutant une conférence, mais il était capable de se réveiller soudainement et de poser une question très pointue et pertinente (un erreur de signe au tableau etc.).

Le besoin de tout théoriser pouvait étonner les personnes à côté de lui. Un jour qu’il discutait avec Piotr Kapitsa (1894-1984), Prix Nobel en 1978, il regardait en même temps l’épouse de celui-ci, Anya, tricoter à leur côté. Après la discussion, Paul Dirac s’est approché d’elle, assez excité : « You know, Anya, watching the way you were making this sweater, I got interested in the topological aspect of the problem. I found that there is another way of doing it and that there are only two possible ways. One is the one you were using ; another is like that… » [Vous savez, Anya, en regardant la manière dont vous réalisez ce pull, je me suis intéressé à l’aspect topologique du problème. J’ai conclu qu’il y a une autre manière de le faire et qu’il n’y avait que deux méthodes possibles. L’une est ce que vous faites ; l’autre est comme ça…] tout en montrant cette seconde manière avec ses longs doigts : il venait de réinventer le "purling" (le fait de tricoter à l’envers).

La femme, une équation à une inconnue

La personnalité de Paul Dirac était à la fois rigoureuse et peu conviviale. Il avait très peu d’amis, aimait bien la solitude qui lui permettait de réfléchir à ses travaux. Il était connu pour sa faible empathie. La seule fois où il a pleuré de sa vie d’adulte, c’était lorsqu’il avait appris la mort d’Albert Einstein en 1955.

Une anecdote donne une idée de sa très faible sociabilité. Le physicien n’était pas marié en août 1929, tout comme son collègue Werner Heisenberg. À l’occasion d’un colloque au Japon (déjà évoqué ci-dessus), comme ils étaient du même âge et encore célibataires, ils pouvaient discuter ouvertement des "femmes". Werner Heisenberg était un homme à femmes avec qui il aimait flirter et danser, tandis que lui restait renfermé. Paul Dirac lui demandait : « Pourquoi danses-tu ? » et Werner Heisenberg de répondre : « Quand il y a des filles charmantes, c’est un plaisir ! » mais Paul Dirac ne comprenait toujours pas : « Mais, Heisenberg, comme peux-tu savoir avant que ce sont des filles charmantes ? ».

Un jour, au cosmologiste George Gamow (1904-1968), Paul Dirac expliqua qu’il y avait une distance optimale pour regarder le visage d’une femme. Théoricien, il évaluait tous les cas : à l’infini, on ne voit rien ; à zéro, l’image est trop déformée et on voit beaucoup trop les imperfections de la peau, les rides. Georges Gamow lui a alors demandé : « Tell me, Paul, how close have you seen a woman’s face ? » [Dis-moi, Paul, à quelle distance as-tu déjà regardé le visage d’une femme ?] et Paul Dirac de répondre : « Oh, about that close ! » [Oh, à peu près cette distance], en montrant ses mains à deux pieds de distance.

Paul Dirac se maria tardivement pour l’époque, en janvier 1937 à Londres avec Margit Wigner (Manci), la sœur d’Eugene Wigner, et, bien qu’indispensable pour lui supprimer toutes les préoccupations matérielles de la vie quotidienne, il la considérait plus comme la sœur de son ami que comme son épouse, et la présentait à ses amis ainsi : « Oh ! I am sorry. I forgot to introduce you. This is… this is Wigner’s sister ! » [Oh ! Je suis désolé. J’ai oublié de te présenter. C’est… c’est la sœur de Wigner !]. Elle-même s’était présentée auprès de George Gamow ainsi : « That what Dirac actually says is : "This is Wigner’s sister, who is now my wife" ! » [Ce que dit habituellement Dirac est "C’est la sœur de Wigner, qui est maintenant ma femme" !]. Margit Wigner, née deux ans après lui, le 17 octobre 1904, disparut le 9 juillet 2002, près de dix-huit ans après lui.

La retraite en Floride

À la fin de sa vie, de 1971 à 1984, Paul Dirac a continué à travailler en choisissant le Florida State University (Université de l’État de Floride). Pour lui, c’était un lieu agréable car il n’avait pas un traitement différent des autres, ses collègues le considéraient comme n’importe qui d’autre, malgré son Nobel et ses travaux prestigieux. Il ne voulait surtout pas se faire remarquer.

En dépit de son caractère peu sociable, Paul Dirac a laissé un souvenir très attachant dans cette université où ses collègues ont pu apprécier sa curiosité intellectuelle, sa passion et sa capacité à la transmettre aux autres. Certes, il pouvait déjeuner (dans la cuisine du bâtiment) avec des collègues (comme Steve Edwards) sans sortir un mot pendant le repas. John Albright se souvenait ainsi : « Dirac était très avare avec les mots. Il n’emploierait pas cinq mots quand un seul pouvait suffire. ». Bien avant, ses collègues de Cambridge avait même inventé une nouvelle unité pour plaisanter, le "dirac" qui correspondait à un mot par heure !

Il adorait marcher, considérait que c’était essentiel pour réfléchir, il marchait ainsi de sa résidence à son bureau, par tous les temps (conduire l’aurait empêché de réfléchir à la physique quantique), il aimait aussi se baigner dans un lac même en hiver, et il était un passionné d’alpinisme, il escaladait beaucoup de montagnes (dans le Caucase par exemple) et lorsqu’il enseignait à Cambridge, on pouvait parfois le voir, pour s’entraîner, grimper aux arbres dans les collines environnantes tout en portant son habituel costume noir.

Ne pas s’occuper de l’extérieur

Homme introverti par excellence, Paul Dirac a donc été avant tout un génie cérébral. Il fallait bien cela pour avoir les quelques intuitions qui l’ont placé, malgré lui, sur le piédestal de la théorie quantique.

Son père l’avait peut-être coupé de toute ambition affective, mais il l’avait encouragé à approfondir les mathématiques qui l’avaient passionné dès son enfance. Sa modestie l’a emporté : à l’égal d’un Newton, d’un Maxwell, d’un Einstein ou d’un Bohr, qui connaît donc Dirac en dehors de la communauté scientifique internationale, trente ans après sa mort ?

Aussi sur le blog.

Sylvain Rakotoarison (20 octobre 2014)

http://www.rakotoarison.eu

Pour aller plus loin :

Paul Dirac.

Livre à télécharger : "Les Principes de la mécaniques quantique" par Paul Dirac.

La théorie des électrons et des positrons (communication du 12 décembre 1933 à télécharger).

La genèse de la théorie relativiste des électrons de Paul Dirac (à télécharger).

Niels Bohr.

Albert Einstein.

L’attribution des Prix Nobel, une dérive depuis plusieurs décennies ? (octobre 2007).

Dirac, Einstein and physics (2 mars 2000).

Paul Dirac : the purest soul in physics (1er février 1998).

Une biographie de référence a été publiée le 22 janvier 2009 :

"The Strangest Man, The Hidden Life of Paul Dirac, Quantum Genius"

par Graham Farmelo (éd. Faber and Faber).

https://rakotoarison.over-blog.com/article-sr-20241020-dirac.html

http://rakotoarison.hautetfort.com/archive/2024/10/20/article-sr-20241020-dirac.html

/image%2F1488922%2F20241010%2Fob_a78d2d_yartinobel2024ia01.jpg)

/image%2F1488922%2F20241010%2Fob_834f61_yartinobel2024ia05.jpg)

/image%2F1488922%2F20241010%2Fob_fc3977_yartinobel2024ia03.jpg)

/image%2F1488922%2F20241010%2Fob_46d48b_yartinobel2024ia04.jpg)

/image%2F1488922%2F20241010%2Fob_1e2d6c_yartinobel2024ia02.jpg)